hive的使用场景及其原理

来源:未知 时间:2018-21-25 浏览次数:323次

HIVE的使用场景及其原理,在大数据处理中HIVE占有很重要的地位,呢么hive到底适合在什么场景使用个,以及如何使用呢?Hive是建立在Hadoop (HDFS/MR)上的用于管理和查询结果化/非结构化的数据仓库;一种可以存储、查询和分析存储在Hadoop 中的大规模数据的机制;Hive 定义了简单的类SQL 查询语言,称为HQL,它允许熟悉SQL 的用户查询数据;允许用Java开发自定义的函数UDF来处理内置无法完成的复杂的分析工作;Hive没有专门的数据格式(分隔符等可以自己灵活的设定);

一、使用场景

Hive不适用于在线事务处理。 它最适用于传统的数据仓库任务,Hive的执行延迟比较高,因为hive常用于数据分析的,对实时性要求不高;Hive优势在于处理大数据,对于处理小数据没有优势,因为hive的执行延迟比较高。

二,hive安装及使用

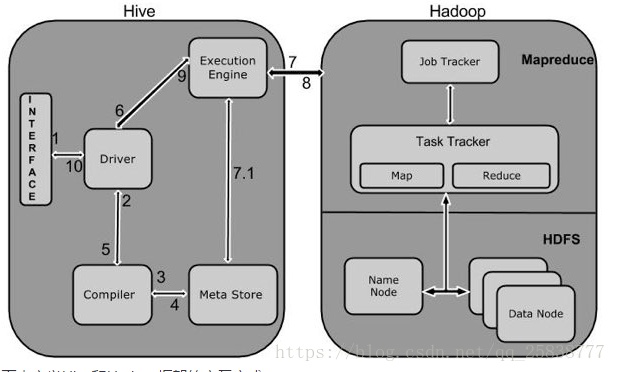

1 Execute Query

1 Execute Query

Hive接口,如命令行或Web UI发送查询驱动程序(任何数据库驱动程序,如JDBC,ODBC等)来执行。

2 Get Plan

在驱动程序帮助下查询编译器,分析查询检查语法和查询计划或查询的要求。

3 Get Metadata

编译器发送元数据请求到Metastore(任何数据库)。

4 Send Metadata

Metastore发送元数据,以编译器的响应。

5 Send Plan

编译器检查要求,并重新发送计划给驱动程序。到此为止,查询解析和编译完成。

6 Execute Plan

驱动程序发送的执行计划到执行引擎。

7 Execute Job

在内部,执行作业的过程是一个MapReduce工作。执行引擎发送作业给JobTracker,在名称节点并把它分配作业到TaskTracker,这是在数据节点。在这里,查询执行MapReduce工作。

7.1 Metadata Ops

与此同时,在执行时,执行引擎可以通过Metastore执行元数据操作。

8 Fetch Result

执行引擎接收来自数据节点的结果。

9 Send Results

执行引擎发送这些结果值给驱动程序。

10 Send Results

驱动程序将结果发送给Hive接口。Hadoop中实际应用,通过上面流程解释,要想在hadoop中使用hive,至少需要安装hive和Metastore(任何数据库)本文安装mysql 。

三、mysql安装

在hive中mysql作为hive元数据存储引擎,下载linux环境下的mysql安装包,并安装,hive的数据存储分为两部分,一部分是基础数据存储在hadoop分布式文件系统hdfs中,另一部分是元数据及hive表,数据库结构存储在关系型数据库中,如mysql等

在hive中mysql作为hive元数据存储引擎,下载linux环境下的mysql安装包,并安装,hive的数据存储分为两部分,一部分是基础数据存储在hadoop分布式文件系统hdfs中,另一部分是元数据及hive表,数据库结构存储在关系型数据库中,如mysql等

- 上一篇: 农业大数据应用经典案例

- 下一篇: hive数据同步工具Sqoop的使用

扫一扫

扫一扫